Buscar este blog

En este espacio exploramos los componentes fundamentales de la infraestructura tecnológica detrás de la inteligencia artificial (IA). Desde el procesamiento de datos y las herramientas de aprendizaje automático hasta el despliegue de modelos, aquí encontrarás información clave sobre cómo construir y gestionar un 'Tech Stack' de IA. A través de distintos artículos, abordaremos cada capa crítica que da forma al ecosistema tecnológico de la inteligencia artificial.

Destacados

- Obtener enlace

- X

- Correo electrónico

- Otras aplicaciones

Conclusiones

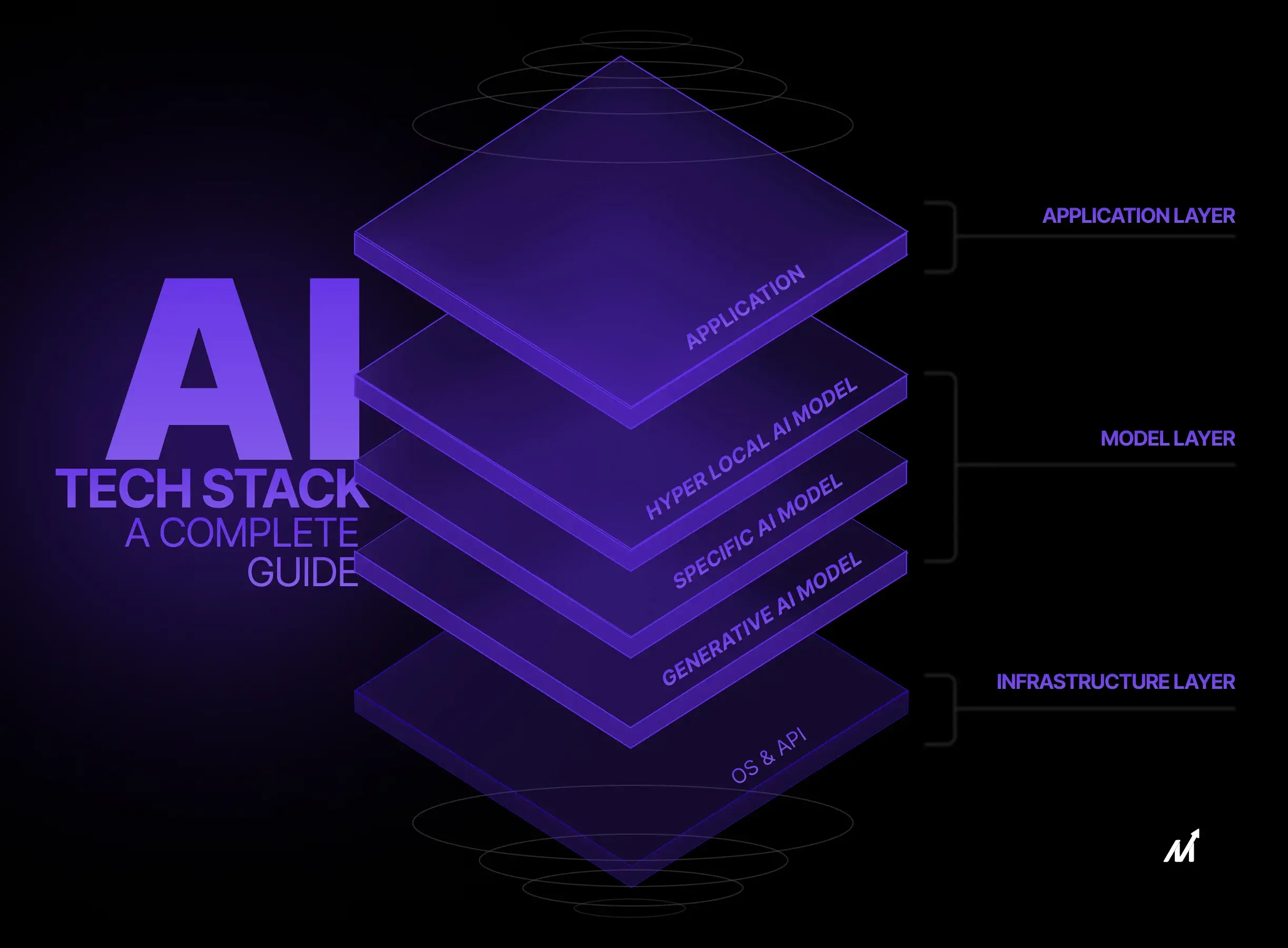

El AI Tech Stack representa un ecosistema tecnológico compuesto por herramientas, infraestructuras y metodologías esenciales para el desarrollo, implementación y despliegue de soluciones de inteligencia artificial (IA). La construcción de un AI Tech Stack eficiente es fundamental para optimizar los procesos de desarrollo, garantizar la escalabilidad, fortalecer la seguridad y mejorar el rendimiento de los modelos de IA. En este contexto, resulta imprescindible analizar sus principales componentes y su impacto en el ámbito de la inteligencia artificial.

Dentro de los componentes fundamentales del AI Tech Stack, se incluyen tanto el hardware como el software y la infraestructura subyacente, los cuales permiten el entrenamiento y la inferencia de modelos de IA. Estos elementos abarcan desde servidores físicos y plataformas en la nube hasta herramientas específicas de desarrollo y despliegue.

El hardware también desempeña un papel crucial, ya que el procesamiento de modelos de IA requiere una gran capacidad computacional. Las GPU (Unidades de Procesamiento Gráfico) y TPU (Unidades de Procesamiento Tensorial) son dispositivos especializados que permiten realizar cálculos de manera eficiente en paralelo, reduciendo significativamente los tiempos de entrenamiento. Asimismo, la capacidad de almacenamiento y la velocidad de procesamiento de los servidores influyen directamente en la eficiencia con la que se gestionan grandes volúmenes de datos.

El procesamiento de datos dentro del AI Tech Stack es esencial, puesto que los modelos de IA dependen de conjuntos de datos estructurados y no estructurados para su entrenamiento. Técnicas como la limpieza, normalización y transformación de datos permiten mejorar su calidad, asegurando predicciones más precisas y confiables.

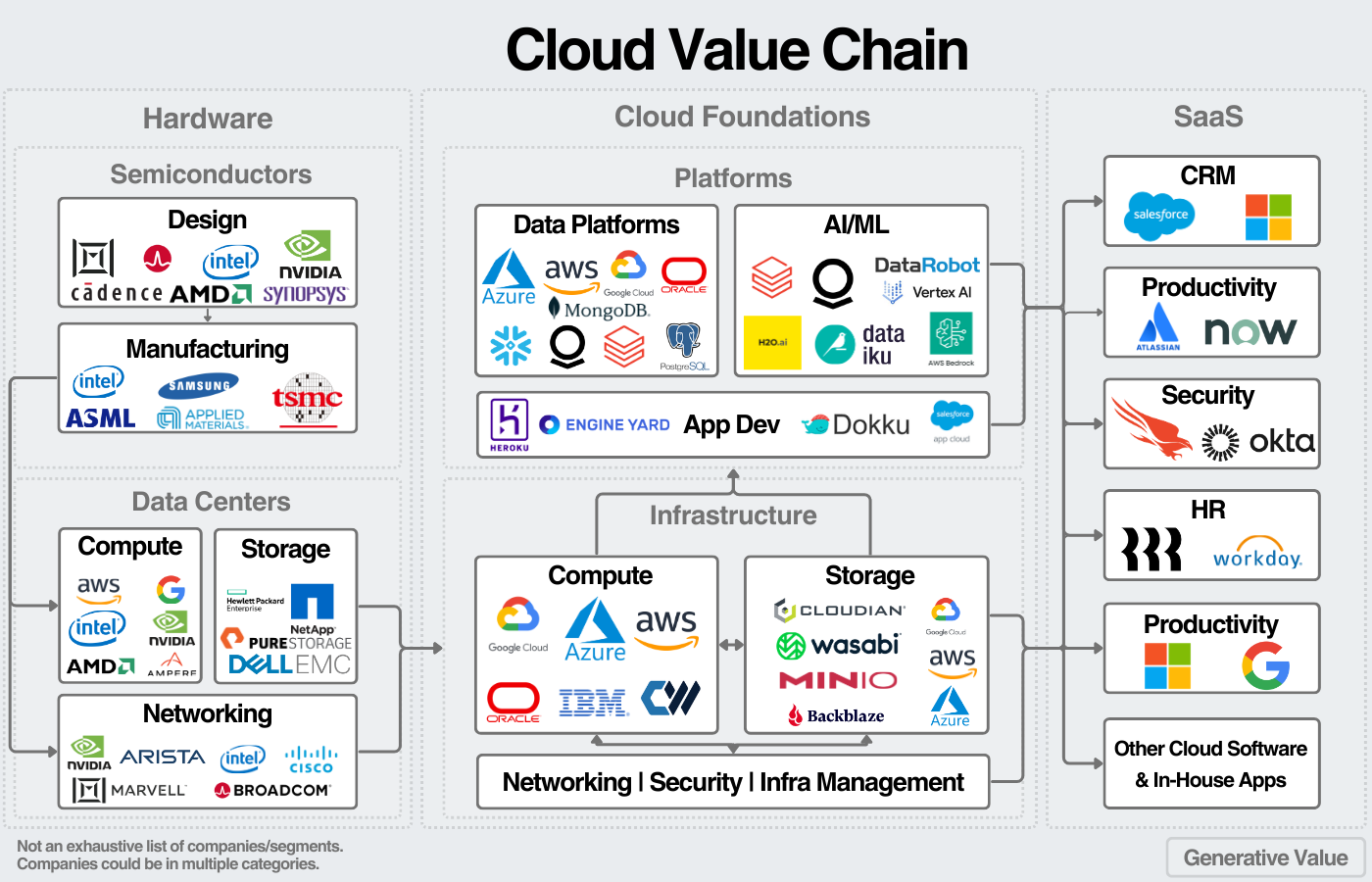

Título: Estructura del Cloud AI Tech Stack

https://blog.publiccomps.com/content/images/2024/08/Cloud-Value-Chain.png

El uso de Cloud Computing ha revolucionado la gestión del AI Tech Stack al ofrecer acceso a recursos computacionales escalables bajo demanda. Plataformas como AWS, Google Cloud y Microsoft Azure facilitan la administración de infraestructura y almacenamiento, además de proporcionar servicios especializados en inteligencia artificial y aprendizaje automático.

El desarrollo de modelos se ve favorecido por frameworks y bibliotecas de Machine Learning, como TensorFlow, PyTorch y Scikit-learn, que ofrecen herramientas optimizadas para la construcción y entrenamiento de modelos. Estos frameworks simplifican la implementación de algoritmos avanzados y mejoran su rendimiento en hardware especializado.

Los lenguajes de programación como Python, R y Julia son esenciales en este ecosistema. En particular, Python destaca por su amplio ecosistema de bibliotecas dedicadas a la inteligencia artificial y su capacidad de integración con diversas tecnologías.

Las bases de datos desempeñan un rol central en la gestión de información utilizada para el entrenamiento de modelos de IA. Tecnologías como MongoDB, PostgreSQL y Redis permiten almacenar y procesar datos de manera eficiente, asegurando su disponibilidad en tiempo real.

Los modelos pre - entrenados ofrecen una alternativa práctica para reducir costos computacionales y acelerar el desarrollo de soluciones de IA. Modelos como BERT, GPT y ResNet proporcionan arquitecturas avanzadas que pueden ser ajustadas a necesidades específicas mediante técnicas de transferencia de aprendizaje.

El uso de APIs en un AI Tech Stack facilita la integración de modelos de IA en aplicaciones finales. APIs enfocados en visión artificial, procesamiento de lenguaje natural y análisis de datos permiten acceder a funcionalidades avanzadas sin necesidad de desarrollar modelos desde cero.

Las prácticas de MLOps han emergido como una disciplina clave en la gestión y automatización del ciclo de vida de los modelos de IA. Estas prácticas garantizan la reproducibilidad, escalabilidad y mantenimiento eficiente de los modelos en entornos de producción.

La seguridad en un AI Tech Stack es un factor crítico, ya que los sistemas de IA manejan información altamente sensible. Implementar mecanismos de encriptación, control de acceso y auditorías constantes son estrategias esenciales para prevenir vulnerabilidades y ataques cibernéticos.

El despliegue de modelos en entornos productivos implica la optimización de su rendimiento y accesibilidad mediante el uso de tecnologías como contenedores Docker y plataformas de orquestación como Kubernetes, que permiten escalar los modelos de manera eficiente.

Finalmente, las aplicaciones finales del AI Tech Stack abarcan diversos sectores, incluyendo salud, finanzas, manufactura y servicios. Desde sistemas de recomendación y asistentes virtuales hasta diagnósticos médicos automatizados, la IA está transformando industrias y optimizando procesos operativos.

En resumen, el AI Tech Stack es un ecosistema dinámico que requiere la integración estratégica de hardware, software y metodologías para desarrollar soluciones de inteligencia artificial eficientes y escalables. Su correcta implementación permite maximizar el impacto de la IA en distintos sectores, fomentando la innovación y mejorando la competitividad en el ámbito global.

- Obtener enlace

- X

- Correo electrónico

- Otras aplicaciones

Comentarios

Publicar un comentario